Nesta publicação irei demonstrar como configurar o PySpark no Google Colab de forma simples. Para os iniciantes na linguagem, é uma ótima forma de praticar e, para os mais avançados, uma boa opção para realizar testes de novas funcionalidades. Vamos praticar!

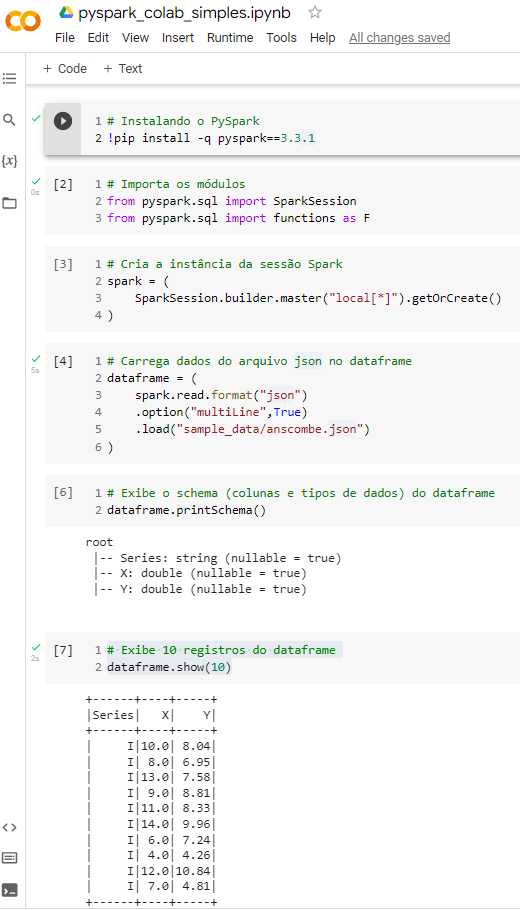

# Instalando o PySpark

!pip install -q pyspark==3.3.1

# Importa os módulos

from pyspark.sql import SparkSession

from pyspark.sql import functions as F

# Cria a instância da sessão Spark

spark = (

SparkSession.builder.master("local[*]").getOrCreate()

)

# Carrega dados do arquivo json no dataframe

dataframe = (

spark.read.format("json")

.option("multiLine",True)

.load("sample_data/anscombe.json")

)

# Exibe o schema (colunas e tipos de dados) do dataframe

dataframe.printSchema()

# Exibe 10 registros do dataframe

dataframe.show(10)

Code language: Python (python)